HiRA: parameter efficient Hadamard high rank adaptation for Large Language Models

HiRA: parameter efficient Hadamard high rank adaptation for Large Language Models

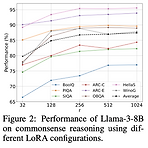

ICLR2025논문의 내용과 상관없이, 제가 이야기해보고 싶은 부분은 이탤릭체로 남깁니다.texts with Italic represent parts that are not the part of the original paper, but rather my personal thoughts or additionsLimitation of the LoRALoRA and most of its variants do not perform well when applied to complex tasks—such as commonsense reasoning.This degradation might be inevitable since the additional trainable parameters are “lower-ran..

Showing off studying ML/ML - 특집

2025. 2. 11. 11:36

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- loss-weighting

- finetuning

- deeplearning4science

- vscode

- 몽중식

- LLM

- generativemodeling

- 프렌밀리

- icml2024

- 이문설농탕

- Theme

- ICML

- Transformer

- domaingeneralization

- MachineLearning

- multiheadattention

- DeepLearning

- flowmatching

- diffusion

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

글 보관함